신경망(Neural Network)

-인간의 두뇌를 모방한 연결주의의 대표적 AI기술

-안정적인 학습 기능, 병렬처리와 에러 감내 등의 장점

-초기부터 음성, 영상, 자연어 처리 등에 많은 응용

신경망 모델링

인공신경망의 학습

: 학습데이터를 입력으로 사용

학습과정에서 학습데이터에서 추출한 지식이 뉴런 간의 연결강도에 반영됨.

=> 학습은 가중치와 편향을 적합한 값으로 변경하는 작업임

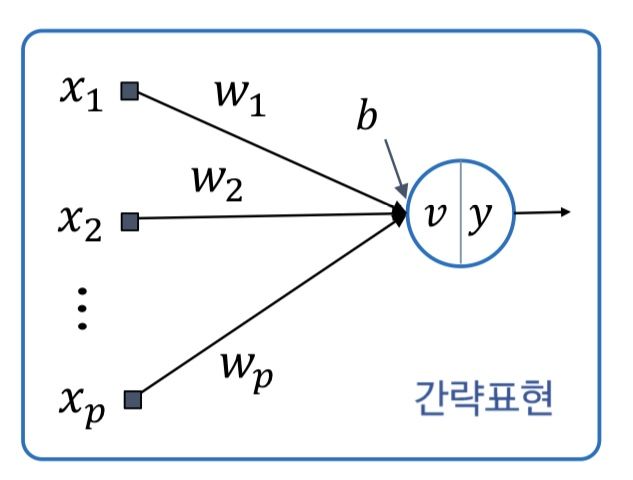

뉴런의 연산 모델

v=(x1*w1+x2*w2+...+xi*wi) + b

가중입력합 v에서 편향을 제외한 값을 순수 가중입력합 이라고 부른다.

편향은 뉴런 입력과 별도로 뉴런에 가해지는 값으로, 순수 가중입력합에 어파인 변환을 적용하는 효과임.

활성화

활성화 함수는

: 입력가중합이 어떻게 처리되는지 결정

응용에 맞는 컴퓨팅 요구에 부합하는 함수를 사용

활성화함수의 종류

- 선형(Linear) 함수

- Piecewise-linear function

- 시그넘 함수(계단 함수)

- ReLU

- 로지스틱 시그모이드

- Hyperbolic tangent function

선형 함수

:입력이 곧 출력

시그넘,step,계단 함수

:

입력값이 특정 임계값보다 작으면 0, 크면 1을 출력한다. 위 예시에서는 임계값이 0으로, 0보다 작은 입력값은 0을, 0보다 큰 입력값은 1을 출력한다. 주로 퍼셉트론에서 사용되며, 선형 분류 문제에 사용된다.

시그모이드 함수

:

시그모이드 함수는 S자 형태의 곡선을 가지며, 입력값이 커질수록 출력값이 1에 가까워지고, 입력값이 작을수록 출력값이 0에 가까워진다. [0,1]범위의 출력 값을 갖기 때문에 출력값이 확률인 경우에도 사용 가능하다. 또한, 미분 가능하기 때문에 기울기 강하 기반 신경망 학습에 적합하다.

ReLU 함수

:

입력값이 양수일 경우는 입력값을 그대로 반환하고, 입력값이 음수일 경우 0을 반환하는 함수이다. 기울기 소실 문제를 어느정도 해결할 수 있어 딥러닝에서 많이 사용된다.

퍼셉트론의 구조와 동작

퍼셉트론은 위와 같다.

퍼셉트론의 뉴런은 시그넘 함수의 수정본이 사용되어,

출력은 1 또는 -1이 된다.

'2023-1 > 인공지능' 카테고리의 다른 글

| FNN 원리와 구현 (0) | 2023.04.19 |

|---|---|

| 퍼셉트론의 학습 (0) | 2023.04.19 |

| 신경망, 퍼셉트론 (0) | 2023.04.19 |

| 넘파이를 알아보자(numpy) (0) | 2023.04.18 |

| 퍼셉트론의 이해 (0) | 2023.03.25 |

댓글